Gemini 3.1 Pro: el nuevo “cerebro” de Google para razonamiento, agentes y código

Hay lanzamientos que se sienten como “una versión más”, y otros que mueven el piso porque cambian lo que consideras posible automatizar o construir en una tarde. Gemini 3.1 Pro cae en la segunda categoría: Google lo presenta como su modelo más capaz para tareas complejas, con foco en razonamiento y en flujos reales para developers.

Por qué todos están hablando de Gemini 3.1 Pro

El interés no viene solo del hype: Google está empujando Gemini 3.1 Pro en lugares donde de verdad se construye producto, como Gemini API (AI Studio), Gemini CLI, Android Studio y Google Antigravity, además de Vertex AI para el mundo enterprise. En pocas palabras, no es “un modelo para probar”, sino una pieza que Google quiere ver funcionando dentro de herramientas y pipelines.

Qué trae de nuevo

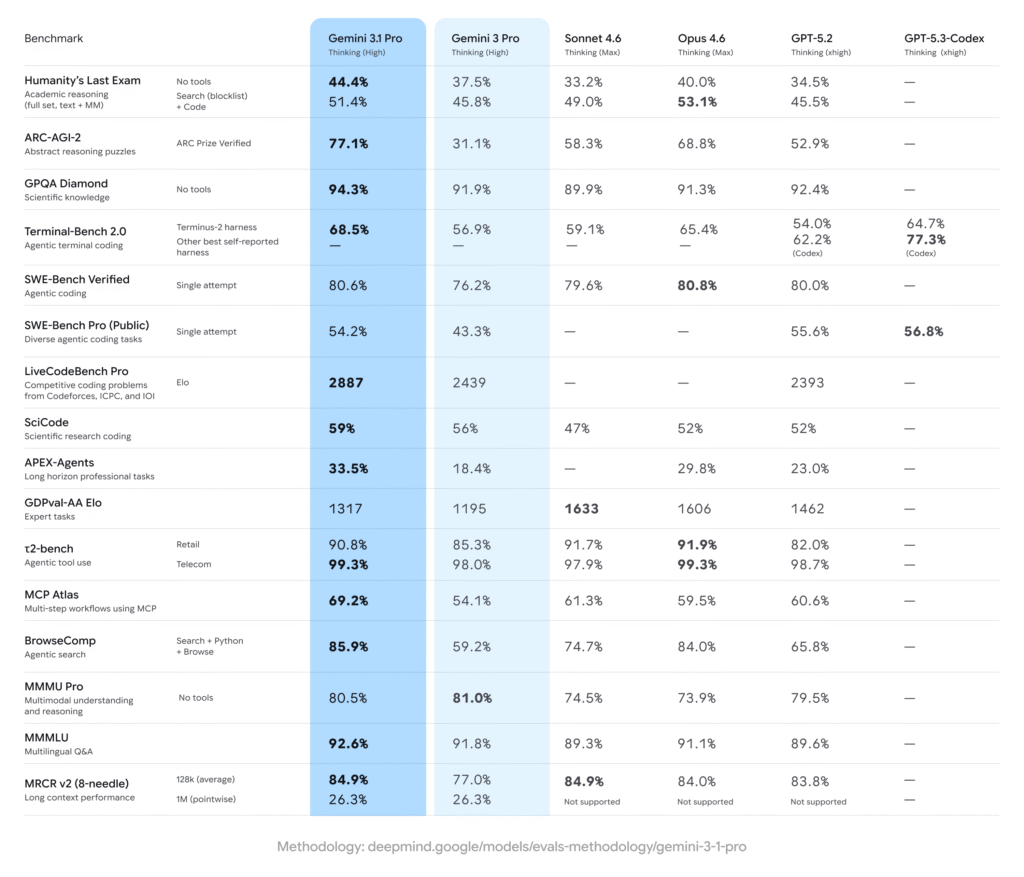

La promesa central es mejor razonamiento para problemas difíciles, de esos donde no basta con “responder bonito” sino entender restricciones, planear pasos y mantener consistencia. Como señal pública de ese salto, Google reporta en ARC-AGI-2 (benchmark de patrones lógicos nuevos) un 77.1% verificado, y afirma que es más del doble del rendimiento de razonamiento de Gemini 3 Pro.

Otro punto clave: el model card lo describe como nativamente multimodal, es decir, pensado para trabajar con texto, audio, imágenes, video y hasta repositorios completos de código. Eso importa porque muchas tareas “del mundo real” no llegan en un solo formato: un agente puede leer un brief (texto), revisar capturas (imagen) y luego modificar un proyecto (código).

De la teoría a lo práctico: Antigravity, agentes y frontends

Si te interesa el lado “construible” (prototipos, interfaces y apps), Google muestra ejemplos donde Gemini 3.1 Pro genera SVGs animados listos para web a partir de un prompt, con la ventaja de que el resultado es código editable y escalable. También lo ilustran como capaz de convertir APIs complejas en experiencias más amigables (por ejemplo, un dashboard que configura y visualiza telemetría pública).

Ese enfoque conecta directo con Antigravity: el post oficial de Google Antigravity sobre Gemini 3.1 Pro lo presenta como una expansión de la serie Gemini 3 y recalca un avance significativo en razonamiento fundamental. Si quieres leer ese ángulo (muy orientado a “agentic dev”), aquí está el artículo: Gemini 3.1 Pro en Google Antigravity.

Ahora, bajándolo a un stack típico de automatización: si tu meta es usar Gemini 3.1 Pro en agentes dentro de n8n (ventas, soporte, agenda, CRM), un patrón común es conectar modelos vía un “router” para centralizar credenciales y manejo de proveedores. En Azul School, la clase de Implementación de OpenRouter en n8n se enfoca justamente en integrar OpenRouter en n8n para gestionar múltiples APIs/modelos (mencionan OpenAI y Gemini) con una sola credencial y pago.

Y si lo tuyo es crear producto (no solo automatizar), el siguiente paso natural es construir un frontend para tus flujos: paneles, chat de atención, consola interna o dashboard de operaciones. La clase de Frontend para n8n con Google Antigravity plantea este enfoque con Antigravity, y se complementa con una sesión donde se trabaja un frontend en Django con PostgreSQL y chat en tiempo real para visualizar/controlar conversaciones.

Conclusión: la pregunta importante no es “qué tan listo es”, sino “qué te permite construir”

Gemini 3.1 Pro suena a “modelo nuevo”, pero en el fondo es una invitación a replantear tu límite: ¿qué procesos todavía mantienes manuales porque “la IA se equivoca”, y cuáles podrían volverse confiables con mejor razonamiento y una arquitectura bien armada? Si lo piensas como herramienta, la ventaja no está en que responda mejor, sino en que puede ser el motor detrás de agentes, interfaces y automatizaciones que antes eran demasiado frágiles para producción.

Respuestas